Als je begin 2024 nog nooit van ChatGPT gehoord hebt, dan heb je waarschijnlijk erg weinig nieuwsberichten gezien. Binnen slechts vier maanden na de introductie in Nederland heeft deze AI-tool van OpenAI, bekend als generatieve kunstmatige intelligentie (Generatieve AI), al 1,5 miljoen Nederlandse gebruikers aan zich gebonden[1]. Deze vorm van AI bootst de neurale structuur van het menselijk brein na met behulp van uitgebreide datasets, waardoor het in staat is om nieuwe content zoals tekst, afbeeldingen of spraak te genereren. Het kan bijvoorbeeld een lang PDF-document samenvatten, een e-mail herschrijven wanneer je vastzit, of complex jargon simpel uitleggen zodat je altijd bent voorbereid. Generatieve AI begint al een verschil te maken op de werkvloer door saaie of uitgestelde taken te automatiseren, waardoor professionals hun creativiteit beter kunnen benutten.

In de zorg zou Generatieve AI bijvoorbeeld kunnen helpen door zorgmedewerkers uit te rusten met een AI-registratietool. Dit zou de registratie van patiënten vereenvoudigen, zodat zorgverleners meer tijd kunnen besteden aan hun patiënten in plaats van aan administratieve taken.

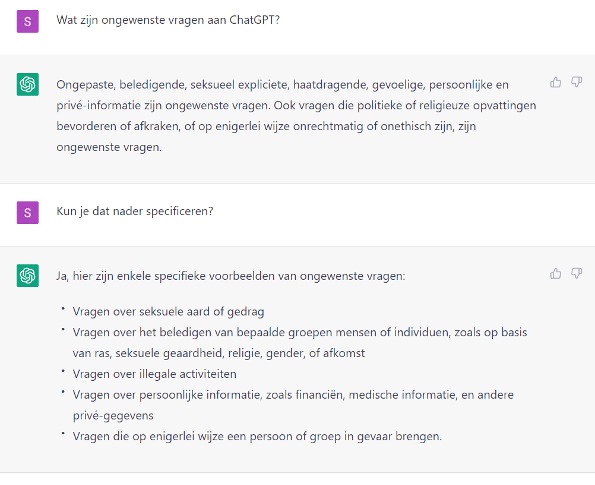

Het gebruik van Generatieve AI-tools gaat gepaard met zowel ethische als juridische risico’s. Bij gratis chatbotdiensten is vaak onduidelijk wie de eigenaar is van ingevoerde data waarmee de tool getraind is, met mogelijke lekken van persoons- en bedrijfsgegevens tot gevolg. Dit leidde tot voorzichtigheid bij eenbedrijf als Samsung, die het gebruik van ChatGPT beperkte na incidenten met bedrijfsgeheimen[2]. Generatieve AI vereist uitgebreide datasets voor training, vergelijkbaar met de levenslange leerervaring van een mens. Echter, het verkrijgen van deze data gebeurt soms onder bedenkelijke omstandigheden, door personeel met lage lonen en onzekere arbeidsvoorwaarden[3]. Bovendien komt data scraping voor, waarbij grote hoeveelheden data zonder expliciete toestemming wordt verzameld. Dit heeft geleid tot juridische vraagstukken, zoals de rechtszaak tegen Meta in de VS. Een lagere rechter in Californië heeft onlangs uitgesproken dat dit geen schending van het auteursrecht is, maar de discussie blijft open[4]. Dit soort vraagstukken heeft bijgedragen aan het kabinetsstandpunt van staatssecretaris Van Huffelen, die pleit voor zorgvuldig gebruik van Generatieve AI in overeenstemming met bestaande wet- en regelgeving[5]. De VNG heeft hierop gereageerd met een verzoek om de mogelijkheden van Generatieve AI verantwoord te verkennen binnen gemeentes[6].

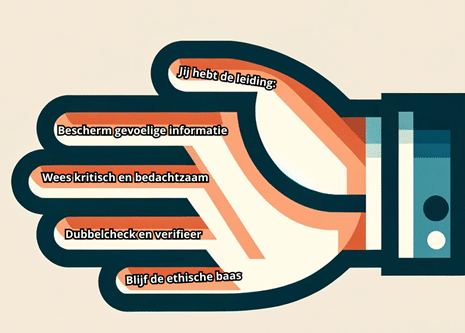

De huidige discussie rond Generatieve AI onthult twee cruciale aspecten. Enerzijds zijn de voordelen van Generatieve AI onmiskenbaar, vooral in het licht van het huidige arbeidstekort en de potentie om de efficiëntie binnen de publieke sector te verbeteren. Anderzijds mogen de aanzienlijke risico’s die aan Generatieve AI kleven niet worden genegeerd. Daarom heb ik vijf belangrijke vuistregels opgesteld om Generatieve AI op een verantwoorde wijze te gebruiken, waarmee de grootste risico’s effectief kunnen worden gemitigeerd.

- Bescherm gevoelige informatie:

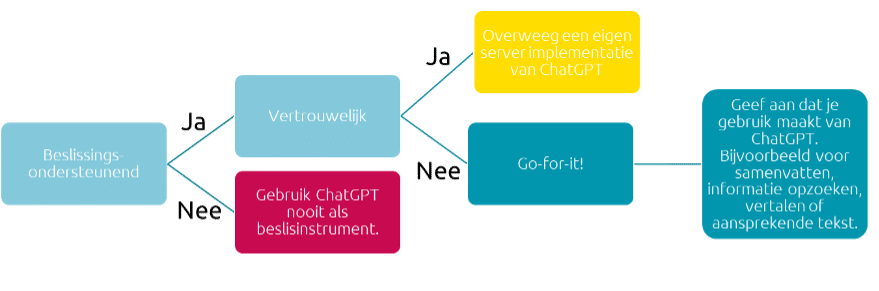

Gebruik Generatieve AI veilig door geen persoonlijke of vertrouwelijke informatie te delen bij je vraagstelling. Zie het als een openbaar dagboek: deel alleen wat je openlijk zou bespreken.

- Jij hebt de leiding:

Blijf altijd de dirigent: Generatieve AI kan suggesties doen, maar de eindbeslissing over de resultaten en de controle hiervan liggen bij jou. Gebruik het als een adviestool, niet als besluitvormer.

- Dubbelcheck en verifieer:

Controleer altijd de output van Generatieve AI. Zie het als een ruwe schets die je zelf verfijnt en aanpast aan je behoeften, om te zorgen voor de nauwkeurigheid en relevantie die jij nodig hebt.

- Wees kritisch en bedachtzaam:

Behandel Generatieve AI als een informatieve bron zoals Wikipedia: nuttig voor algemene kennis, maar vertrouw niet blindelings op de nauwkeurigheid. Gebruik het als een startpunt voor verder onderzoek.

- Blijf de ethische baas:

Herinner jezelf eraan dat jij de baas bent; Generatieve AI is jouw digitale assistent. Jij bepaalt wat goed en slecht is, ga dus goed om met die verantwoordelijkheid. Doe geen dingen die niet juist voelen.

[1] https://www.rtlnieuws.nl/tech/artikel/5378644/chatgpt-app-nederland-chatbot

[2] https://www.cnbc.com/2023/05/02/samsung-bans-use-of-ai-like-chatgpt-for-staff-after-misuse-of-chatbot.html

[3] https://eenvandaag.avrotros.nl/item/geen-bescherming-weinig-loon-en-onduidelijk-wie-je-werkgever-is-het-trainen-van-kunstmatige-intelligentie-heeft-een-schaduwzijde/

[4] https://www.reuters.com/legal/litigation/us-judge-trims-ai-copyright-lawsuit-against-meta-2023-11-09/

[5] https://www.rijksoverheid.nl/actueel/nieuws/2023/12/11/voorlopig-standpunt-generatieve-ai-kabinet

[6] https://vng.nl/nieuws/vng-reageert-op-kamerbrief-generatieve-ai

Hoe ChatGPT veilig en verantwoord in te zetten in de publieke sector? Ontdek deze vuistregels

Deze vuistregels bieden een solide basis voor het gebruik van generatieve AI, terwijl de risico’s worden geminimaliseerd.

Op 23 januari 2024 zal ik samen met Fenna Zeilmaker ook een webinar geven over de praktische en verantwoorde inzet van ChatGPT. Aanmelden kan via deze link: https://www.vka.nl/evenement/webinar-praktische-tips-voor-chatgpt-in-de-publieke-sector/#aanmelden

Voor meer informatie over de toepassing van generatieve AI in jouw organisatie, of advies over het navigeren door de bijbehorende risico’s en kansen, neem gerust contact met mij op via erik.deruiter@vka.nl of bel 06 57 44 60 78.